前言:

近年来,人工智能大模型技术呈现爆发式增长,模型参数规模从亿级迅速扩展至万亿级。

根据最新研究显示,全球AI算力需求正以每3~4个月翻番的速度突破临界点,远超传统摩尔定律预测的计算能力提升速度(每18个月翻倍),形成了所谓的"逆摩尔定律"。

IDC预测,2023-2030年全球IDC市场将保持高速增长,其中AI算力需求增速显著高于传统算力。

作者| 方文三

图片来源|网 络

2025年,全球AI大模型技术呈现出快速迭代、规模持续扩大、效率显著提升的发展趋势。以OpenAI的GPT系列为代表,从GPT-3的1750亿参数发展到GPT-4的预估1.7万亿参数规模,再到GPT-5可能达到3至50万亿参数,模型参数量呈指数级增长。

Meta的Llama系列作为开源大模型的标杆,2025年4月发布的4.0版本首次采用MoE(Mixture of Experts)架构,提供了三个不同规模的版本:Llama 4 Scout(1090亿参数)、Llama 4 Maverick(4000亿总参数,170亿激活参数)和Llama 4 Behemoth(2万亿总参数,2880亿激活参数,16个专家),展现了大模型架构的创新方向。

在技术架构方面,Transformer已成为大模型的主流架构基础,同时各种创新变体不断涌现。MoE(混合专家模型)架构通过动态路由机制,在保持模型容量的同时显著降低了计算成本;

世界模型(World Models)探索构建对环境的内部表征,为实现更通用的人工智能提供了新思路;

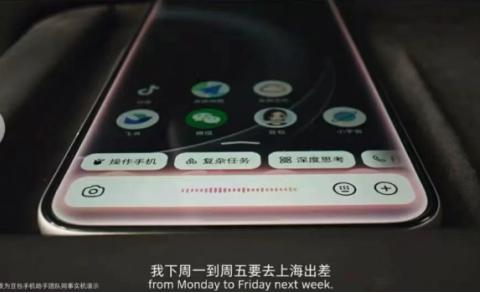

多模态能力成为大模型的标配,从单一的文本处理扩展到图像、音频、视频等多种模态的理解和生成。

2025年8月,Anthropic发布Claude Opus 4.1,将编码性能提升至SWE-bench Verified基准测试的74.5%,显著增强了深度研究和数据分析能力。

中国在大模型领域的发展呈现出"提质增效"的态势,涌现出一批具有国际竞争力的模型和产品。阿里巴巴的通义千问(Qwen)系列在开源社区备受关注,通过持续迭代优化,在多模态理解和生成方面取得显著进展。

华为的盘古大模型在千亿级参数基础上,进一步优化了训练效率和推理性能,覆盖NLP、科学计算等多个领域,并在华为的全栈AI生态中得到广泛应用。

以下是《AI大模型与异构算力融合技术白皮书》部分内容: