近日,Cohere 联合了 119 个国家和地区共 3,000 名研究员,发布了一个名为 Aya 的语言模型系列。

图源:Cohere

Aya 目前包含两个语言模型,其中 Aya 101 涵盖了 101 种语言,专注于语言的广度;而 Aya 23 则通过将高性能的预训练模型与最近发布的 Aya 数据集集合配对,专注于深度,只服务于 23 种全球范围使用最广泛的语言,Aya 23 还有 80 亿和 350 亿两种不同的参数大小。

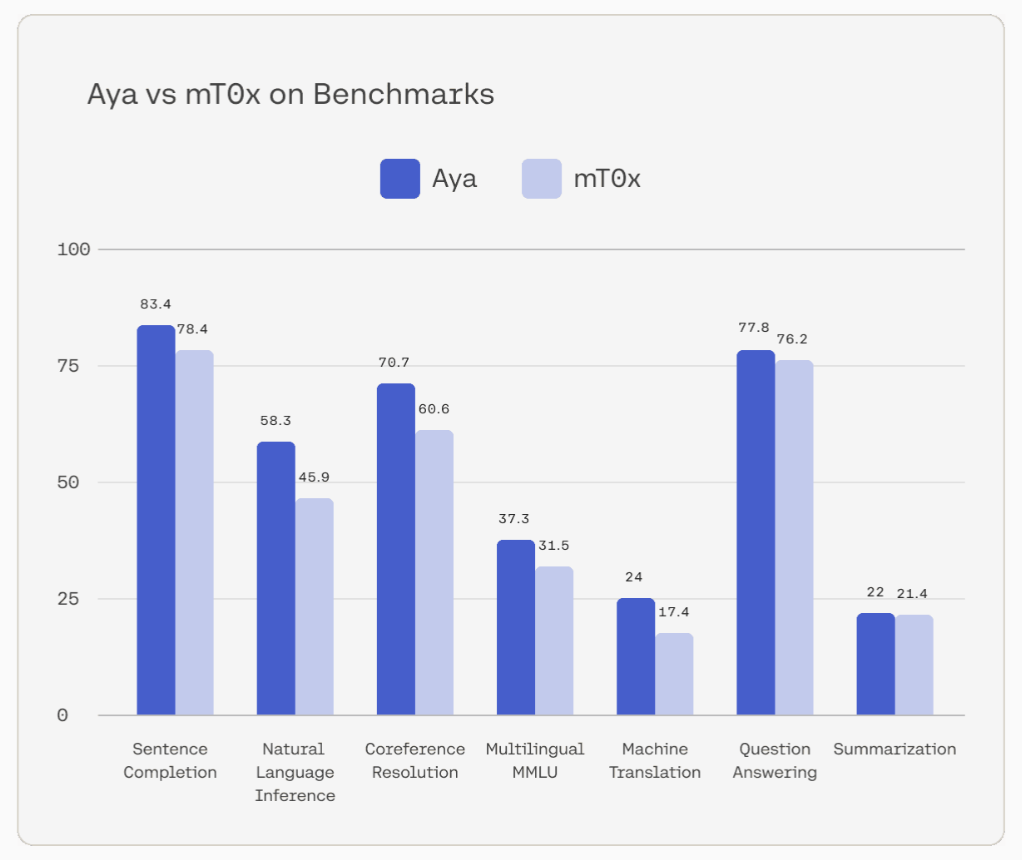

图源:Cohere

在涵盖了 100 种语言的一系列任务的基准测试中,Aya 模型在所有任务中的表现均优于 mT0x,显示出其在各种类型的任务中都具有卓越的多语言能力。

除了公布语言模型,Cohere 还一同开源了用于语言模型训练所需的数据集 —— Aya Collection。这个数据集被官方誉为迄今为止最全面的多语言教学微调数据集,包含了 114 种语言的 5.13 亿条提示和完成情况。

来源:Cohere