前言:

随着2024年的到来,大型语言模型的光环似乎正在逐渐减弱,而模型的小型化已成为本年度语言模型发展的主要趋势。

回顾2023年,尽管[百模大战]竞争激烈,但大型语言模型在商业价值上的表现相对有限。

相反,小型语言模型在成本和效率方面展现出了更为显著的优势。

作者| 方文三

图片来源|网 络

谷歌Gemma 2 2B小模型发布

近日,Google正式发布了其Gemma系列开源语言模型的最新更新,这一举措在AI领域引起了强烈反响。

据Google Developer官方博客宣布,与先前发布的27B和9B参数版本相比,此次推出的全新2B参数模型在保持卓越性能的基础上,实现了[更小、更安全、更透明]的显著进步。

Gemma 2 2B版本作为蒸馏学习技术的结晶,不仅在NVIDIA TensorRT-LLM库上进行了优化,还展现出了在多种硬件平台——从边缘设备到云端——上的卓越运行能力。

尤为值得一提的是,其较小的参数量极大地降低了研究和开发的门槛,使得该模型能够在Google Colab的免费T4 GPU服务上流畅运行,为用户提供了一种既灵活又成本效益高的解决方案。

与早先版本相比,Gemma 2 2B模型在保持卓越性能的同时,实现了模型体积的缩减、安全性的提升以及透明度的增强。

该模型能够高效运行于广泛的硬件环境之中,包括边缘设备、笔记本电脑以及依托Vertex AI和Google Kubernetes Engine(GKE)的强大云部署环境。

为了进一步提升运行效率,Gemma 2 2B还利用NVIDIA TensorRT-LLM库进行了优化,并作为NVIDIA NIM提供,以适应包括数据中心、云端、本地工作站、PC以及边缘设备在内的各种部署场景。

此外,Gemma 2 2B模型无缝集成了Keras、JAX、Hugging Face、NVIDIA NeMo、Ollama、Gemma.cpp等开发工具,并将很快支持MediaPipe,从而大幅简化了开发流程。

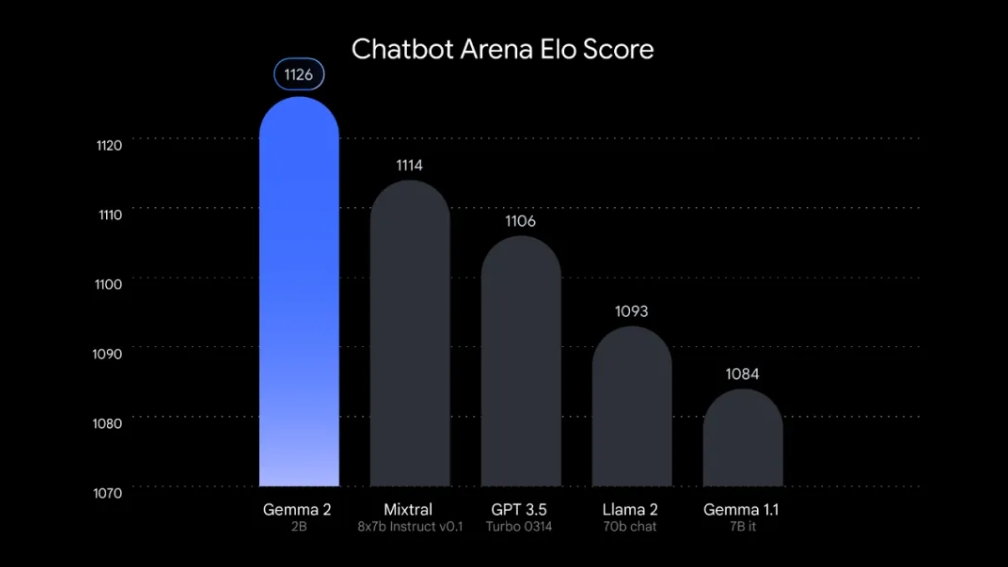

在大型模型竞技场LMSYS Chatbot Arena中,Gemma 2 2B凭借其仅20亿的参数量便取得了1130分的高分,这一成绩甚至超越了GPT-3.5-Turbo和Mixtral-8x7b等模型,展现了其卓越的性能。

谷歌的Gemma 2 2B轻量级模型以其卓越的性能和灵活的部署选项,成功挑战了[模型越大越好]的传统观念。

通过先进的训练技术和高效的架构设计,该模型在保持较小体积的同时,实现了与大型模型相媲美的性能表现。

其广泛的适用性和经济高效性也为开发者提供了极大的便利和选择空间。

同时,Gemma 2 2B的开源性和易访问性也赢得了业界的广泛赞誉,用户可以轻松下载模型权重并在多个平台上进行试用和开发。

谷歌SLM技术的具体细节和创新点

谷歌SLM技术,即Small Language Models(小语言模型),是谷歌在人工智能领域的一个重要研究方向。

SLM技术专注于开发参数规模较小、运行效率高的语言模型,以适应各种边缘设备和应用场景的需求。

稀疏自动编码器(SAE):Gemma Scope使用SAE作为[显微镜],帮助研究人员观察语言模型内部,从而更好地理解工作原理。

知识蒸馏技术:Gemma 2模型在训练过程中采用了知识蒸馏技术,通过一个大型模型作为教师,最小化学生模型与教师模型在每个token的条件概率分布之间的负对数似然。

这种方法可以在有限的计算资源下,让小模型获得类似于训练更多token的效果。

谷歌SLM技术的具体细节和创新点,不仅展示了谷歌在小模型领域的技术实力,也为AI领域带来了新的发展方向和可能性。

ShieldGemma+Gemma Scope的两大亮点

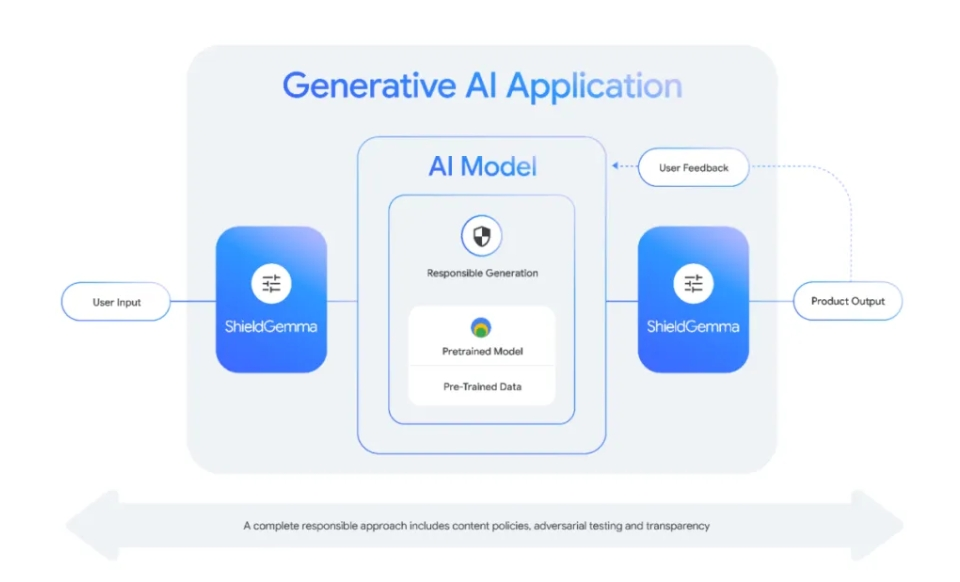

Gemma 2的显著优势不仅体现在其推出的更轻量级[Gemma 2 2B]版本,更在于其创新性地集成了[ShieldGemma]安全内容分类器模型及[Gemma Scope]这一模型可解释性工具。

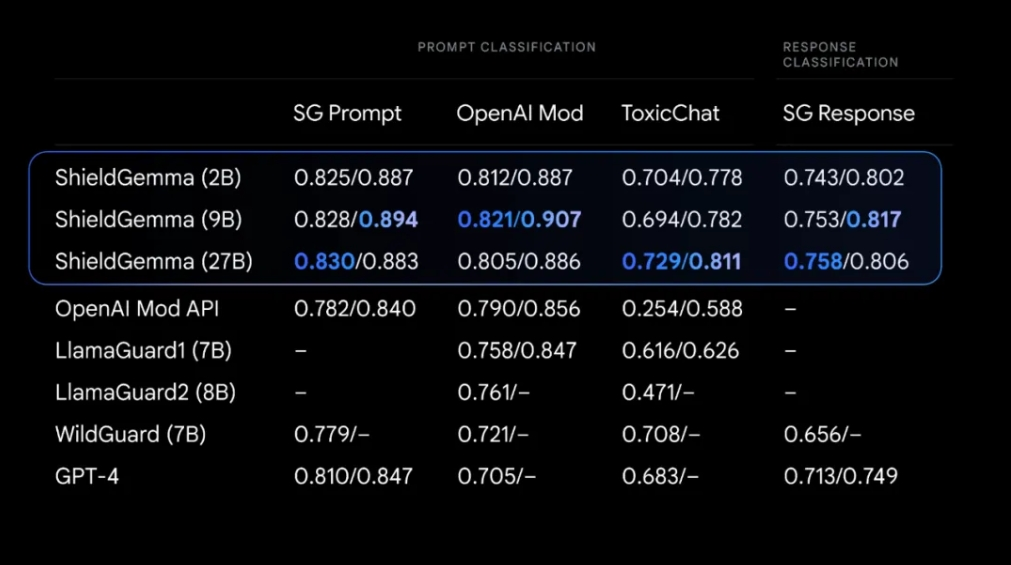

ShieldGemma分类器模型,作为对现有负责任AI工具包的重要补充,旨在精准检测并有效缓解AI模型输入输出中的有害内容,具体涵盖仇恨言论、骚扰、色情内容及危险内容等四大关键危害领域。

其设计高度针对且实用,为开发者提供了部署AI模型时更为负责任的解决路径。

此外,ShieldGemma以其开放分类器的特性,展现了卓越的灵活性与集成能力,能够无缝融入各类AI应用场景,从而显著提升这些应用的安全性与可靠性。

而Gemma Scope则代表了Gemma 2模型在可解释性领域的又一重大突破。

受Deepmind可解释性语言模型研究团队的启发,Gemma Scope致力于为研究人员提供深入了解Gemma 2语言模型内在逻辑的窗口,推动可解释性研究的深入发展。

具体而言,Gemma Scope犹如一台精密的显微镜,运用稀疏自编码器(SAE)技术,将Gemma 2模型的内部运作机制放大至前所未有的清晰度,使得复杂处理过程变得直观易懂。

借助Gemma Scope,研究人员能够深入洞悉Gemma 2识别模式、处理信息及做出预测的机制,获取宝贵的研究见解。

Gemma Scope的开创性在于其多项核心优势:

①提供超过400个免费的SAE,全面覆盖Gemma 2 2B及9B版本的所有层级,为用户提供了广泛的选择空间;

②配备交互式演示功能,用户无需编写代码即可在Neuronpedia平台上直观体验SAE的各项功能,深入分析模型行为;

③建立易于使用的存储库,包含与SAE及Gemma 2交互所需的代码与实用示例,极大地降低了用户的使用难度。

开源AI模型在今年的发展趋势

技术创新:开源AI模型在技术创新方面取得了显著成就,例如Meta发布的Llama 3.1-405B模型,拥有4050亿个参数,是Meta迄今为止最大的开源模型之一。

此外,黑森林实验室推出的Flux.1开源图像生成模型,在技术上取得突破,提供多种版本以满足各种用户需求。

开源AI模型在多个行业中找到了实际应用,如智能搜索、智能翻译、智能风控、城市管理等领域。

这些应用案例展示了开源AI模型在提升各行业生产要素产出效率、提高数据要素在生产要素组合中的地位方面的潜力。

尽管开源AI模型发展迅速,但仍面临多方面的挑战,包括算力瓶颈、主流大模型架构的局限、高质量训练数据集不足、缺乏爆款级应用等。

开源AI模型的未来发展趋势包括AI云侧与端侧大模型将满足不同需求,AI大模型将趋于通用化与专用化,AI大模型将广泛开源,小型开发者可以调用大模型能力提升开发效率等。

结尾:

谷歌通过发布诸如Gemma 2 2B、ShieldGemma及Gemma Scope等模型,旨在以多样化的途径助力开发者、研究人员及终端用户更加深入地理解与驾驭AI的行为模式。

此举旨在提供必要的工具与资源,以推动AI技术的透明度与可解释性,从而构建一个使AI技术惠及每一位个体的未来愿景。

部分资料参考:AI科技评论:《谷歌 Gemma 2 2B 发布火爆,小模型如何撑起大格局?》,CSDN:《谷歌又[卷]出了端侧小模型 Gemma 2 2B》