文/VR陀螺 WiZ

在元宇宙投入看不到回报的局面下,Meta 将目光重新转向了 AI。

1月19日,Meta CEO 扎克伯格在 Instagram 上分享了一则短视频,主角悄然从此前时常在其社交媒体中刷脸的 Quest 系列变成了 AI。

在视频中,扎克伯格强调,“这项技术(AI)非常重要”、“ 下一代服务需要构建全面的通用智能、构建最佳的 AI Agent、面向创作者的人工智能、面向企业的人工智能”。

这看起来是 Meta 想要将 AI 作为实现元宇宙愿景抓手的一次强调。毕竟 Meta 元宇宙业务不温不火,而其在 AI 市场却表现出色。仅从市场来看,在 AI 领域的投入帮助 Meta 在今年三季度实现净利润增 164%。扎克伯格本人更是直接表示 AI 将成为 Meta 2024 年最大投资领域。

如今,随着扎克伯格计划将 Meta AI 基础设施上升至 60 万台 H100 数量级,AI 在 2024 年已经被 Meta 寄予了拯救元宇宙帝国的厚望。

图源:网络

生成式AI工具是搭建元宇宙的刚需

对于 AI,Meta 更关注也更得心应手的还是与元宇宙高度适配的 AIGC 模型,在扎克伯格的元宇宙设想中,AI 不仅能完成从文字到图像、文字到三维模型的跨越,同样也要能做到文生视频。

去年 9 月,Emu(Expressive Media Universe)在 Meta Connect 大会上首次亮相。彼时,扎克伯格还将 Emu 定位为 Meta AI 的 Imagine 功能的动力来源,并计划与 Meta 旗下 Facebook、Instagram 等社交平台深度绑定。

但不久前,这一项目终于有了新进展。Meta 在其官方网站展示了两个基于 Emu 的 AI 新工具:Emu Edit 和 Emu Video,不仅在图像生成上实现了扎克伯格当初夸下的海口,甚至还出人意料地造出了当下热门的“AI 生成视频”功能。

其中,Emu Edit 旨在为用户提供对图像编辑的精细控制。其类似于 Adobe Photoshop 此前推出的“生成填充”功能,开创了一种独特的图像处理方法,用户可以输入基于文本的指令来更改图像。

Emu Video 则区别于图像编辑,它是一种专门的增强视频生成技术,能够响应包括纯文本、纯图像在内的各种输入,提供了一种简单的文本到视频生成方法。

图源:Emu Video

对于将元宇宙作为企业代名词的 Meta 来说,元宇宙的风已经开始转向 AI+虚拟现实,AI 工具 Emu Video 和 Emu Edit 的出现自然也被视作 Meta 推进人工智能驱动内容生成的一项战略举措。

特别是 Emu Video,在 Meta 的描述中,其将成为 Runway 和 Pika Labs 等热门品牌的主要竞争对手,有助于将创作权利下放给“有想法的人”而不只是专业内容创作者。

在一篇博客文章中,Meta 的 AI 研究人员解释说,AI 图像生成通常是一个循序渐进的过程,用户尝试提示,生成的图片并不能百分百完全符合他们的想法,用户将需要不断调整提示,直到创建的图像更接近他们想象的图像。

AI 视频生成同样如此,为了减少生成过程复杂性,Emu Video 选择了一种更为聪明的办法,通过细致拆分操作过程并采用文本+图像兼容输入的方式优化生成结果准确性。

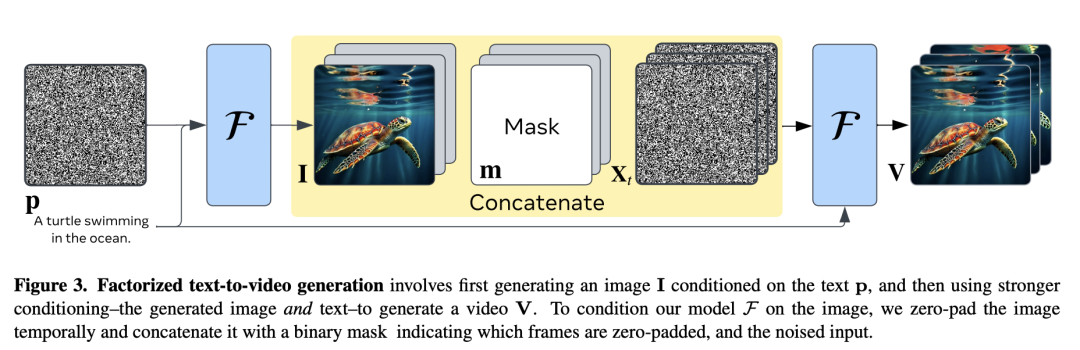

具体来看,Emu Video 在 Emu 模型基础上,利用了一种基于扩散模型的文本到视频生成的简单方法,通过明确的图像条件来分解文本到视频生成的过程。

图源:Emu Video

在 Emu Video 的应用场景下,文本到视频生成分解为两个子问题:首先生成图像,然后使用生成的图像和文本生成视频。通过将文本到图像模型与视频生成模型解耦,Emu Video 能够在生成高质量视频的同时保留文本到图像模型的视觉多样性、风格和质量。与先前的方法相比,Emu Video 在 MSVD 和 MSR-VTT 数据集上实现了最先进的性能。

图源:Emu Video

相关论文中,Emu Video 项目的研究人员表示这种视频生成的“因式分解”方法使得有效地训练视频生成模型成为可能,因式分解的视频生成可以通过单一扩散模型实现。研究人员只需要提出关键的设计决策,例如调整视频扩散的噪声时间表,就能直接生成更高分辨率视频的多阶段训练。

Emu Video 简化了视频生成过程,无需像 Make-A-Video 那样需要更复杂的多模型方法,仅使用两个扩散模型就能以每秒 16 帧的速度生成 512x512 像素大小的 4 秒视频。

同时,由于输入文本的连贯性,Emu Video 能够准确地将文本转换为连续的视觉叙事,这一点有别于大多数现有模型和商业解决方案。

图源:Emu Video

与现有的文本到视频生成方法相比,由于训练模型时使用了包含 3400 万个经过许可的视频-文本对的完整数据集,Emu Video 在视频质量和准确度方面都表现更好,同时模型也更简单,只有两个模型级联,参数量更小,总共只有 60 亿个参数。

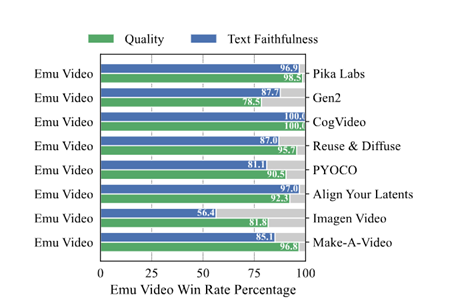

并且在人类评估中,Emu Video 也获得更多好评,相比 Make-A-Video,96%的受访者认为 Emu Video 生成的视频质量更好,85%的受访者认为 Emu Video 对于文本理解的准确度要更胜一筹。

在人类评估中,Emu Video 生成的视频在质量上相比于 Google 的 Imagen Video,提高了 81%;相比于 Nvidia 的 PYOCO,提高了 90%;相比于 Meta 的 Make-A-Video,提高了 96%;与商业解决方案 RunwayML 的 Gen2 和 Pika Labs 相比同样更具优势。

研究人员对 Emu Video 的评估结果(图源:Emu Video)

Meta AI 改变元宇宙社交体验

目前,Emu Video 和 Emu Edit 仍在开发中,没有确定公开发布的时间表。但 Meta 积极的生成式 AI 研究预示着更多变革性的元宇宙社交体验即将到来。

作为一家社交媒体起家的科技企业,Meta 如果只靠单纯的硬件系统是无法搭建起能用的元宇宙的,一个完整的元宇宙空间刚需海量的内容生产。

但依靠专业从业人员的 PGC 内容生产方式成本过高,依靠用户生成的 UGC 方式又难以确保内容质量,因此,节约人力、提升效率、同时又有生成内容质量下限保证的 AIGC 内容方式成为一种更佳的选择,将有助于元宇宙快速构建包括文字、语音、3D 图像、视频等多媒体内容基础设施。

AI 生成 3D 建模(图源:Stability AI)

Emu Video 和 Emu Edit 的推出正是建立在 Meta 的元宇宙战略之上,通过平台内的编辑和创建,Meta 能够推动内容创作者在整个元宇宙系统中的参与度,也将用户更牢固地锁定在 Meta 的社交生态中。

同时,这也是 Meta AI 开发过程中至关重要的一环。对于 Meta 来说,在其社交媒体平台上引入基于 AI 的原生图像编辑功能似乎是一件轻而易举的事。有很多类似的工具可用,例如 Google Photos Magic Editor 和 Adobe 的 Photoshop 生成填充,但对于 Instagram 和 Facebook 用户来说,不必跳转到第三方服务显然对于营造独立的元宇宙社区更为方便。

此前,Meta 已展示了 AI 在 3D 图像建模方面的强大生产力。

在 2023 年 9 月份,扎克伯格与麻省理工学院科学家 Lex Fridman 的一番隔空对话成功破圈,相关视频播放量快速突破千万,在社交网络上掀起了一阵 VR 热潮。

在这次对话中,扎克伯格展示了 Meta 的新型 Codec 虚拟现实化身。与 Meta 最初略显简陋的 Horizon Worlds 虚拟卡通化身不同,Codec 会通过头显扫描技术检测并构建用户面部的 3D 模型,再由机器学习实现驱动,实时映射到 3D 化身上形成动作。

从公开的视频来看,大至全身动作,小至表情细节,新形象已经做到和真人几乎一致的自然天成。在扎克伯格的视角看,“这触及了增强现实愿景的核心,即无论你身在世界何处,它都能提供一种临场感。”

图源:YouTube/Lex Fridman Podcast

这是一次成功的营销,Meta 不仅探索了 AI+VR 的另一种选择,还展示了元宇宙社交的新变革。

元宇宙中的社交不用再以简洁的虚拟卡通形象作为脸面,每个人都能在 AI 技术加持下创造出自己的真实扫描建模,而除了普通的日常通信、会议交流之外,生成的逼真建模形象也将可以直接用于视频直播、聊天机器人、企业营销等场景,数字人建模成本直接打骨折。

再加上 Emu Video 的视频生成技术,甚至连数字人动画制作这一步也可以精简,配合 GPT 真正做到“给我一段描述,还你一个有血有肉的复制人”。

当然,要实现这些设想还需要给 AI 们几年时间,毕竟目前看来,无论是 Emu Video 还是 pika,他们的视频成品看起来更像是几张“动起来”的卡通图片的组合,人物动作幅度处处受限,场景切换前后也难以形成逻辑。

图源:Pika 1.0

同时,在模型的训练和推断阶段,Emu Video 也还存在一些不足。但这些问题随着人工智能合成的成熟都将逐一得到解决。

动作方面,不久前,阿里研究团队构建了一种名为 Animate Anyone 的方法,只需要一张人物照片,再配合骨骼动画引导,就能生成自然的动画视频。

图源:Animate Anyone

细微表情方面,慕尼黑工业大学等机构研究人员也提出了 GaussianAvatars 方法,基于三维高斯 splats 可以创建表情,姿态和视角完全可控的逼真头部虚拟。

图源:GaussianAvatars

未来随着多项技术的融合,AI 视频的动作表情将越来越灵动,文生视频技术落地应用正在成为可能。

元宇宙式微,Meta 不得不抓住 AI+内容生态的救命稻草

生成式 AI 热度空前,发展路径已日趋明朗。日前,红杉资本的两位合伙人 Sonya Huang 和 Pat Grady 发表了一篇名为《Generative AI: A Creative New World》的文章,认为 AI 应用发展将遵循从文本、代码、图像、语音领域向视频、3D 领域升级的主要路径。

而从商业市场上看,IDC 在其最近的一份报告中预计全球企业在生成式 AI 上的投资将从 2023 年的超 194 亿美元倍增至 2024 年的 401 亿美元,2027 年将进一步增长至 1511 亿美元。虽然生成式 AI 在 2023 年仅占人工智能总支出的 9%,但该公司预计这一比例将在五年内上升到 28%。

如今,AI 已经深入各行各业,其中就包括已许久未能掀起波澜的元宇宙产业。对于元宇宙来说,AI 目前已经与“内容”深度绑定。

整个互联网时代,内容生产方式几经变化。在 Web1.0 时代,电视、媒体行业主导的 PGC 专业生产内容一家独大;Web2.0 时代,提倡用户自由创作的 UGC 内容模式成为主流。

如今到了 Web3.0 时代,生成式 AI 相关技术的飞速发展使得 AI 写作、AI 编程、AI 绘画等新型内容创作方式开始颠覆内容生产形式。图文、视频、数据等各类信息将融合形成虚实融合的内容生产、传输与呈现体系,为内容行业带来了革命性的变化。

微软旗下免费的生成式 AI 助手 Copilot(图源:微软)

元宇宙场景的搭建需要 AI,元宇宙的交互需要 AI,将元宇宙作为企业标志的 Meta 也需要 AI。

从扎克伯格“All in 元宇宙”开始,Meta 已经在元宇宙项目里亏损了上百亿美元,股价直接性损失了约三分之二。

根据 Meta 第三季度财报显示,该公司第三季度营收为 341.5 亿美元,同比增长 23.2%,比预期高出 7 亿美元,其 GAAP 每股收益为 4.39 美元,也高于预期 0.76 美元,净利润同比飙升 164% 至 115.8 亿美元。

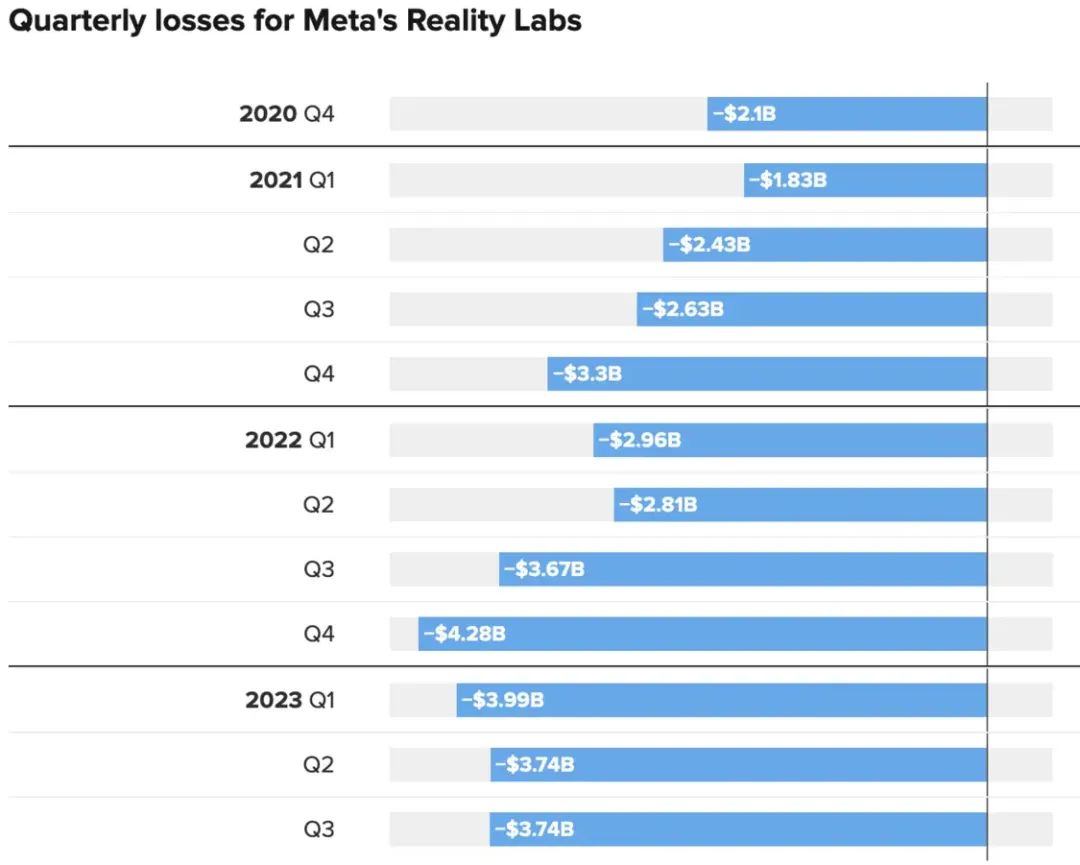

盈利背后,Meta 负责元宇宙业务的 Reality Labs(现实实验室)部门收入仅为 2.10 亿美元,较去年同期的 2.85 亿美元下降 26%,营业亏损扩大至 37.42 亿美元,较去年同期的 36.72 亿美元亏损增加了 2%,同时,Reality Labs 的营业亏损预计将在 2023 年还将继续扩大。

Meta 近年元宇宙部门亏损情况(图源:Meta)

从财报上看,Meta 的元宇宙部门已经连续两年亏损百亿美元以上,2022 年共计亏损 137.17 亿美元,2021 年亏损 101.93 亿美元,再加上今年肉眼可见的颓势,扎克伯格不得不承认失败,并开启成本控制计划,雷厉风行地对元宇宙业务下刀。

裁员之外,Meta 还叫停了部分 VR 设备的生产,表示不会再为 Quest Pro 订购新的零部件,负责组装的歌尔则只会在当前零部件数量允许的情况下生产 Quest Pro。

现在,Meta 还将重心转向了元宇宙之后最为热门的生成式 AI 领域,并在今年 3 月正式发布了大型语言模型 Llama,将 AI 视作公司下一个有可能带动元宇宙的新选择。

在今年 6 月份,Meta 首席执行官扎克伯格向员工宣布了一项计划,将在其旗舰产品(如 Facebook 和 Instagram)中加入生成式 AI 文本、图像和视频生成器,不过扎克伯格将其描述为对元宇宙工作的扩展而非替代 Meta 在那里的重心。

图源:网络

事实上,Meta 一直处于生成式人工智能研究的前沿,但其在将这些技术应用到其产品上方面有些缓慢。扎克伯克表示,过去一年在生成式 AI 方面,我们看到了一些真正令人难以置信、质量上有所突破的进步,这给我们提供了机会,现在可以把这项技术推向前进,并将其构建到我们的每一个产品当中。

或许对于 Meta 来说,元宇宙的步子跨得还是太大,公众似乎还没有完全接受 VR 头显和虚拟世界。因此在没有成熟生态落地之前,让元宇宙成为 AI 的载体或许是推广元宇宙的更加稳妥的选择。

扎克伯格认为,“人工智能驱动的真实性和现实主义将在适当的时候赢得怀疑论者的青睐”。Meta 未来在数字/物理混合世界中生活、工作和娱乐的宏伟愿景将取决于 AI 的持续发展,Meta 将更专注于建立技术基础,并一步一步地将这一科幻愿景变为现实。

图源:雷朋

现在,Meta 和 IBM 联手 40 多家公司组织创建一个致力于开源 AI 工作的行业组织,又联合雷朋筹划搭载 Meta AI 的第二代智能眼镜“Ray-Ban Meta”。

在扎克伯格看来,“眼镜是 AI 的最佳硬件载体”,一手抓 AI,一手抓 XR,放不下“All in 元宇宙”的扎克伯格, 正在全速推进智能 AI 和身临其境的 XR 硬件,等待着 AI 带动元宇宙爆发的那一刻。